![[IMG]](http://www.techpowerup.com/img/13-11-04/HGST_6TB_HE6HDD_comparison.jpg)

HGST, compañía propiedad de Western Digital, ha anunciado hoy en lanzamiento al mercado de sus discos duros Ultrastar He6 que se caracterizan por estar rellenos del gaseoso helio en vez de aire. Con sus 6 TB de capacidad, están pensados para los grandes servidores de datos, citando ellos mismos a los propios de marcas o instituciones como HP, Netflix, Huawai, CERN, Green Revolution Coding o Code42. Este es el disco duro de mayor capacidad disponible en el mercado y es mejor para el almacenamiento en la nube, RAID, entornos replicados y computación en la nube. Los entornos de escalado también se benefician de estas HDDs.

Anunciados el año pasado, HGST prometió que a fines de este año iniciaría la comercialización de sus discos duros llenos de helio, promesa que cumple con su nuevo disco duro Hitachi UltraStar He6.

El disco duro UltraStar He6 posee el formato estándar de 3.5”, junto con un motor y un "pin" de lectura, una velocidad de rotación de 7200 RPM, interfaz SATA-III (6Gbps) además de dejar un mayor espacio para añadir más platos. Así pues, al estar más juntos entre sí, estos HGST Ultrastar He6 cuentan con 7 platos de 877 Gigabytes, frente a los 5 platos con los que cuentan los discos duros normales como máximo, aumentando hasta los 6 Terabytes su capacidad máxima, ofreciendo una un consumo 23% inferior al de discos duros tradicionales de 4 Terabytes.

Gracias a una densidad 7 veces menor que el aire, el helio permite reducir el coste total del producto al reducir el consumo de energía necesario para dar vida a los elementos móviles del disco y reducir las temperaturas. Se consigue así un disco de 3.5” con una capacidad de 6 TB y un peso de 640 gramos que solo consume 5.3W en estado de reposo.

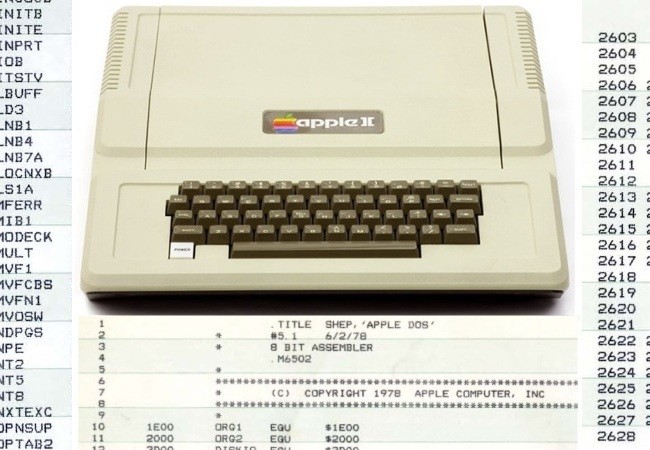

Como podéis ver en la imagen de arriba, además no se aumenta el grosor del disco duro, así que son igualmente discos de 3.5 pulgadas compatibles con lo mismo que los discos duros habituales. Además, es más ligero que las unidades de 3,5 pulgadas estándar, de cinco discos, a pesar del factor de forma idéntico, ya que dado que el helio pesa menos que el aire, estos Ultrastar He6 pesan unos 50 gramos menos que los discos duros normales de 4 TB de capacidad. Además, según el fabricante, estos discos duros tienen el mejor TCO (total cost of ownership) del mercado, dado que consumen un 49% menos de energía por TB que los discos duros convencionales.

Evidentemente, nada de esto sería posible sin que el disco estuviera totalmente sellado del mundo exterior. Para lograr esto, HGST implementó el proceso HelioSeal, que mantiene la HDD herméticamente cerrada para siempre, o al menos hasta que otras piezas fallen, algo que siempre sucede en algún momento.

Este disco duro está enfocado al segmento empresarial (servidores y micro-servidores), pero Hitachi espera tener disponibles dentro de algunas semanas otros discos duros llenos de helio para el mercado de consumo.

![[IMG]](http://www.techpowerup.com/img/13-11-04/HGST_6TB_HE6HDD_comparison.jpg)